1. Введение

Зачем нужен парсинг данных?

Парсинг данных - это процесс извлечения информации из разнообразных источников в формате, доступном для анализа и обработки компьютерной программой. Это важное звено в сфере аналитики и исследований, так как позволяет автоматизировать процесс сбора и обработки данных.

Парсинг данных необходим во многих сферах деятельности, начиная от маркетинга и исследований рынка, и заканчивая научными исследованиями и финансовым анализом. Например, для маркетинговых целей парсинг данных помогает собирать информацию о конкурентах, ценообразовании на рынке, отзывах клиентов и других важных параметрах, на основе которых можно делать стратегические решения.

В научных исследованиях парсинг данных позволяет обрабатывать огромные объемы информации, содержащейся в научных статьях, базах данных и других источниках. Это помогает ускорить процесс поиска нужной информации, улучшить качество исследований и делать более точные выводы.

Финансовый анализатор, например, может использовать парсинг данных для отслеживания изменений курсов валют, цен на акции, доходов и расходов компаний и других финансовых показателей. Это позволяет делать аналитику на основе актуальных данных и принимать обоснованные инвестиционные решения.

Таким образом, парсинг данных играет важную роль в современном мире, помогая улучшить качество аналитики, сделать более точные прогнозы и принимать обоснованные решения на основе данных.

Какие бывают способы парсинга данных?

Парсинг данных - это процесс извлечения информации из структурированных и неструктурированных источников данных. Существует несколько способов парсинга данных, каждый из которых имеет свои особенности и преимущества.

Один из наиболее распространенных способов парсинга данных - это использование библиотек и инструментов для парсинга HTML, XML или JSON. Например, для парсинга HTML можно воспользоваться библиотеками Beautiful Soup или lxml, которые позволяют удобно извлекать данные из web страниц. Для парсинга XML и JSON часто используются библиотеки ElementTree и json.

Еще один способ парсинга данных - это использование регулярных выражений. Регулярные выражения позволяют искать и извлекать определенные шаблоны данных из текста. Однако использование регулярных выражений требует определенных навыков и может быть не таким удобным, как использование специализированных библиотек.

Также существуют специализированные инструменты для парсинга данных, такие как Scrapy и BeautifulSoup. Эти инструменты предоставляют удобные средства для извлечения данных из различных источников, а также позволяют автоматизировать процесс парсинга.

В зависимости от специфики задачи и формата данных, можно выбрать подходящий способ парсинга. Важно учитывать особенности данных, их объем, структуру и формат, чтобы выбрать наиболее эффективный способ парсинга.

2. Основные библиотеки для парсинга данных в Python

BeautifulSoup

BeautifulSoup - это библиотека для парсинга HTML и XML документов в Python. Она позволяет удобно извлекать информацию из web страниц, обрабатывать её и проводить анализ данных.

Основными возможностями BeautifulSoup являются:

1. Поиск элементов: с помощью методов find() и find_all() можно находить элементы на web странице по различным критериям, таким как тег, класс, id и другие атрибуты.

2. Навигация по дереву элементов: BeautifulSoup позволяет удобно перемещаться по дереву HTML-элементов, получая доступ к родительским, дочерним и соседним элементам.

3. Извлечение текста и атрибутов: библиотека позволяет извлекать текст элементов, их атрибуты, содержимое тегов и другую информацию, необходимую для анализа web страниц.

4. Манипуляция с элементами: с помощью BeautifulSoup можно изменять, удалять и добавлять элементы на web странице, делая её более удобной для дальнейшего анализа данных.

Преимущества использования BeautifulSoup включают простоту использования, гибкость и удобство работы с HTML-документами. Благодаря своей простой и интуитивно понятной API, библиотека позволяет быстро и эффективно обрабатывать данные с web страниц, что делает её широко используемой среди разработчиков и аналитиков данных.

Scrapy

Scrapy - это библиотека для Python, предназначенная для извлечения данных из web сайтов. Она позволяет создавать web паука (web crawlers), которые могут автоматически обходить страницы сайтов, собирать нужную информацию и сохранять ее в удобном формате, например, в базе данных или CSV-файле.

Основными возможностями Scrapy являются возможность работы с различными типами web страниц (HTML, XML, JSON), управление обходом страниц сайта, обработка данных и сохранение результатов. Благодаря гибкой настройке, можно легко адаптировать паука под нужды конкретного проекта.

Основными компонентами Scrapy являются Spiders (пауки), которые определяют правила обхода и сбора данных, Items (элементы), которые представляют данные, которые нужно собрать, и Pipelines (конвейеры), которые отвечают за обработку и сохранение данных. Также в Scrapy есть возможность использовать middleware для настройки обработки запросов и ответов.

Scrapy отличается высокой производительностью и эффективностью, что делает его одним из самых популярных инструментов для парсинга web сайтов. Благодаря документации и активному сообществу разработчиков, Scrapy является удобным и мощным инструментом для извлечения данных из интернета.

lxml

lxml - это библиотека для обработки XML и HTML в языке программирования Python. Она предоставляет удобные средства для работы с XML-документами, позволяя парсить их, а также редактировать и создавать новые.

Одним из основных преимуществ lxml является его быстродействие. Библиотека реализована на языке программирования C, что делает ее очень эффективной и быстрой в работе. Это особенно важно при обработке больших объемов данных или при работе с web страницами.

Еще одним значимым преимуществом lxml является его обширная функциональность. Благодаря разнообразным методам и возможностям библиотеки можно легко извлекать информацию из XML и HTML документов, производить их структурирование, фильтрацию и преобразование.

Кроме того, lxml поддерживает различные стандарты и спецификации XML, такие как XPath, XSLT и XML Schema. Это позволяет использовать библиотеку для выполнения сложных задач по обработке XML данных и документов.

В целом, lxml - мощный инструмент для работы с XML и HTML в Python, который обладает высокой производительностью, обширной функциональностью и поддержкой стандартов. С его помощью разработчики могут эффективно и удобно работать с данными в формате XML и HTML, выполняя разнообразные операции по их обработке и анализу.

3. Пример парсинга данных с использованием BeautifulSoup

Установка и импорт библиотеки

Установка и импорт библиотеки являются важными шагами для работы с программным обеспечением. Для начала следует загрузить необходимую библиотеку с официального ресурса разработчика или использовать менеджер пакетов для установки.

Например, если мы хотим установить библиотеку numpy, мы можем воспользоваться пакетным менеджером pip:

```

pip install numpy

```

После установки библиотеки ее необходимо импортировать в код программы. Для этого используется ключевое слово import, за которым следует название библиотеки. Например:

```

import numpy

```

После этого мы можем использовать функционал библиотеки в нашем коде.

Важно помнить, что при установке и импорте библиотеки необходимо следовать инструкциям разработчика и учитывать совместимость версий с другими установленными библиотеками. В случае возникновения проблем, полезно обратиться к документации библиотеки или сообществу разработчиков для получения помощи.

Установка и импорт библиотеки - это первый шаг к созданию эффективного программного решения, поэтому важно уделить этому процессу должное внимание и выполнить его с аккуратностью и вниманием к деталям.

Поиск и извлечение нужной информации из HTML

Поиск и извлечение нужной информации из HTML - это важный процесс при работе с web данными. HTML является основным языком разметки web страниц, и извлечение информации из него может быть сложной задачей.

Для начала поиска и извлечения информации из HTML необходимо использовать специализированные инструменты или библиотеки, такие как BeautifulSoup, lxml или Scrapy. Эти инструменты позволяют программистам легко обращаться к HTML-коду и получать нужные данные.

Одним из наиболее распространенных методов поиска информации в HTML является использование CSS-селекторов. CSS-селекторы позволяют обращаться к конкретным элементам HTML-кода, таким как заголовки, ссылки или таблицы, и извлекать из них необходимую информацию.

Другим способом извлечения данных из HTML является использование регулярных выражений. Регулярные выражения позволяют искать и извлекать текстовую информацию на основе определенных шаблонов, что может быть полезно при работе с HTML-кодом.

Важно помнить, что при извлечении информации из HTML необходимо быть внимательным к структуре и форматированию web страницы. Изменения в HTML-коде страницы могут привести к ошибкам при извлечении данных, поэтому необходимо следить за обновлениями и вносить соответствующие коррективы в код извлечения информации.

В целом, процесс поиска и извлечения нужной информации из HTML может быть сложным, но с использованием правильных инструментов и методов можно успешно справиться с этой задачей.

4. Полезные советы и приемы при парсинге данных

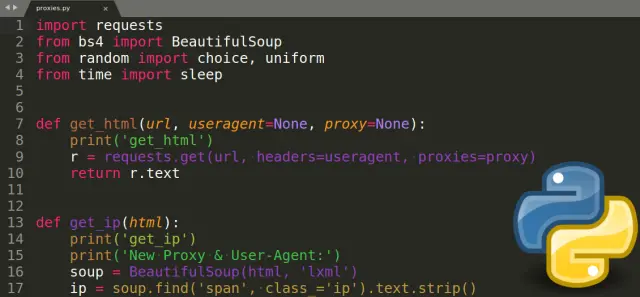

Использование заголовков и прокси-серверов для обхода блокировок

В наше время доступ к информации в интернете может быть ограничен из-за различных блокировок. Но существуют способы обойти такие ограничения, используя заголовки и прокси-серверы.

Заголовки HTTP могут быть использованы для обхода блокировок, так как они содержат важные сведения о запросе, которые могут быть изменены для скрытия настоящего адреса и обхода ограничений доступа к определенным сайтам. Например, вы можете изменить заголовок User-Agent (содержащий информацию о браузере) на другой, чтобы сайт не распознал ваше устройство и разрешил доступ.

Прокси-серверы также могут помочь обойти блокировки, перенаправляя ваш трафик через сторонний сервер, который уже имеет доступ к запрещенным ресурсам. Это позволяет скрыть ваш реальный IP-адрес и обойти блокировки, доступные на уровне вашего интернет-провайдера.

Однако следует помнить, что использование заголовков и прокси-серверов для обхода блокировок может нарушать законы о защите авторских прав или нарушать политику сайта. Поэтому важно быть осторожным и использовать эти методы только в случае необходимости и сознания возможных последствий.

В целом, использование заголовков и прокси-серверов для обхода блокировок может быть полезным инструментом для обеспечения свободного доступа к информации в интернете, но требует соответствующего понимания и ответственности.

Оптимизация парсера для ускорения работы

Оптимизация парсера - это процесс улучшения скорости и эффективности работы парсера, который используется для анализа и обработки данных. Парсеры широко применяются в различных областях программирования, таких как web скрапинг, обработка текстов и многие другие.

Для ускорения работы парсера существует несколько методов оптимизации. Один из способов - использование более эффективных алгоритмов парсинга. Например, если парсер работает с большим объемом данных, то для улучшения производительности можно использовать алгоритмы парсинга, которые имеют лучшую временную сложность.

Еще одним способом оптимизации является использование многопоточности. Путем распараллеливания работы парсера на несколько потоков можно значительно увеличить скорость его работы. Это особенно полезно при парсинге больших объемов данных.

Также важным этапом оптимизации парсера является оптимизация работы с памятью. Неэффективное использование памяти может сильно замедлить работу парсера. Поэтому стоит проанализировать и оптимизировать структуры данных и алгоритмы, которые используются парсером для хранения и обработки данных.

В целом, оптимизация парсера представляет собой сложный процесс, требующий глубокого понимания работы парсера и специфики данных, с которыми он работает. Правильно проведенная оптимизация может значительно увеличить скорость работы парсера и повысить производительность приложения в целом.

Обработка и хранение данных после парсинга

После парсинга данных не менее важным этапом является их обработка и хранение. Обработка данных включает в себя такие процессы как очистка, преобразование и агрегация. Причем каждый из этих шагов имеет свое значение и помогает достичь более точных и полезных результатов.

Очистка данных включает в себя удаление некорректных, дублирующихся или ненужных значений, а также исправление опечаток и ошибок. Этот этап позволяет избежать искажений в данных и обеспечить их качество для дальнейшего анализа.

Преобразование данных часто включает в себя изменение формата или типа данных, например преобразование текстовых значений в числовые или даты. Этот шаг необходим для правильного интерпретации и использования данных в дальнейшем.

Агрегация данных - процесс сведения данных из различных источников или форматов к общему виду для удобного анализа. Например, объединение данных из нескольких таблиц или источников в одну для создания общего отчета или анализа.

Хранение данных также играет важную роль, поскольку от этого зависит их доступность, безопасность и эффективность использования. Для хранения данных могут применяться различные методы и технологии, такие как базы данных, облака или файловые системы. Важно выбрать подходящий способ хранения данных в зависимости от их объема, структуры и требований к безопасности.

Таким образом, обработка и хранение данных после парсинга являются неотъемлемой частью процесса работы с информацией и играют ключевую роль в обеспечении качественного и эффективного анализа данных.

5. Заключение

Важность парсинга данных в контексте анализа информации

Парсинг данных является важным инструментом в области анализа информации, который позволяет автоматически извлекать и структурировать данные из различных источников. Этот процесс не только упрощает сбор информации, но и значительно повышает ее точность и актуальность.

Одним из основных преимуществ парсинга данных является возможность проведения анализа большого объема информации за короткое время. Благодаря автоматизации этого процесса, специалисты могут быстро получить доступ к необходимым данным и сосредоточиться на их анализе, а не тратить время на их поиск и обработку.

Кроме того, парсинг данных позволяет улучшить качество анализа информации за счет исключения ошибок, связанных с человеческим фактором. Автоматическая обработка данных уменьшает вероятность появления неточностей и пропусков, что делает информацию более достоверной и надежной.

Важно отметить, что парсинг данных активно используется в различных областях, таких как маркетинг, финансы, медицина и другие. Благодаря этому инструменту специалисты могут оперативно получать актуальную информацию о конкурентах, рынке, клиентах и других аспектах своей деятельности, что позволяет принимать обоснованные решения и оставаться конкурентоспособными.

Таким образом, парсинг данных играет важную роль в современном анализе информации, обеспечивая специалистам доступ к большому объему данных и повышая их качество и достоверность. Этот инструмент является неотъемлемой частью работы экспертов, которые стремятся быть в курсе всех событий и трендов в своей области.

Плюсы и минусы использования Python для парсинга данных

Python - один из самых популярных языков программирования, используемый для парсинга данных. Его простота и удобство делают его отличным выбором для таких задач.

Плюсы использования Python для парсинга данных:

1. Простота изучения. Python имеет чистый и понятный синтаксис, что делает его доступным даже для начинающих разработчиков.

2. Богатая библиотека. Python обладает обширным набором библиотек, специально предназначенных для парсинга данных, таких как BeautifulSoup и Scrapy.

3. Скорость разработки. Благодаря своей простоте и богатой функциональности Python позволяет быстро создавать скрипты для сбора и обработки данных.

Минусы использования Python для парсинга данных:

1. Низкая скорость выполнения. Python является интерпретируемым языком, что делает его менее эффективным в сравнении с компилируемыми языками, такими как C++ или Java.

2. Подверженность ошибкам. Из-за динамической типизации Python может не обнаруживать некоторые ошибки в коде до момента его выполнения.

3. Ограниченные возможности для параллельной обработки. Python имеет ограниченную поддержку параллельных вычислений, что может замедлить процесс парсинга данных при работе с большими объемами информации.

В целом, несмотря на некоторые недостатки, Python остается одним из лучших выборов для парсинга данных благодаря своей простоте, гибкости и богатой экосистеме библиотек.