1. Введение

Как работает web парсинг и зачем он нужен

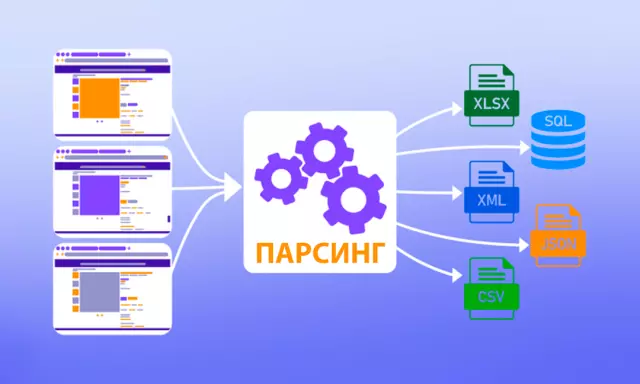

Веб-парсинг - это процесс сбора информации с web сайтов с использованием специальных программ, называемых парсерами. Этот инструмент необходим для получения данных, которые могут быть полезны для анализа, исследований или других целей.

Основной целью web парсинга является извлечение информации с web сайтов в автоматическом режиме. Это позволяет сократить время и усилия, которые были бы потрачены на ручной сбор данных. Вместо того, чтобы проводить многочасовые поиски в Интернете, можно написать скрипт парсера, который будет делать это за вас.

Помимо экономии времени, web парсинг также позволяет получить данные в структурированном виде. Парсеры могут извлекать различные типы информации, такие как текст, изображения, ссылки, цены и многое другое. Эти данные могут быть использованы для анализа рынка, мониторинга конкурентов, создания базы данных и многих других целей.

Однако важно помнить, что web парсинг должен осуществляться в соответствии с законодательством. Некоторые web сайты запрещают извлечение данных без их разрешения, поэтому перед запуском парсера необходимо убедиться, что это допустимо.

Таким образом, web парсинг является мощным инструментом для сбора данных с web сайтов. Он позволяет автоматизировать процесс извлечения информации, экономя время и усилия, и предоставляет возможность получить данные в удобной форме для дальнейшего использования.

2. Основные методы парсинга

Ручной парсинг HTML-страниц

Ручной парсинг HTML-страниц - это процесс извлечения информации из web страниц путем анализа и чтения их HTML-кода. В отличие от автоматического парсинга, где используются специализированные инструменты и библиотеки, ручной парсинг требует от человека прямого взаимодействия с кодом страницы.

Основной задачей при ручном парсинге является поиск и извлечение конкретных данных или элементов со страницы. Для этого специалист должен иметь хорошее понимание языка разметки HTML и знание основных тегов и атрибутов.

Одним из ключевых инструментов при ручном парсинге является браузерный инструмент разработчика, такой как Developer Tools в Google Chrome. С его помощью можно просматривать HTML-код страницы, анализировать структуру и идентифицировать нужные элементы.

Для более эффективного ручного парсинга рекомендуется использовать CSS селекторы, которые позволяют точно указать на нужный элемент на странице. Также полезно использовать XPath для поиска и выбора элементов в XML-документах, что может быть полезно при парсинге сложных структур.

Важно отметить, что ручной парсинг HTML-страниц требует времени и терпения, поскольку требуется внимательный анализ и проверка каждого элемента на странице. Тем не менее, этот метод является эффективным для извлечения данных с web страниц, особенно в случаях, когда автоматический парсер не способен справиться с задачей из-за сложной структуры страницы или нестандартного форматирования.

Использование библиотек для автоматизации процесса парсинга, таких как BeautifulSoup, Scrapy, requests

При автоматизации процесса парсинга важно выбрать подходящую библиотеку, которая обеспечит быструю и эффективную работу. Среди самых популярных инструментов для парсинга web страниц выделяются BeautifulSoup, Scrapy и requests.

BeautifulSoup - это библиотека, которая предназначена для извлечения данных из HTML и XML документов. С помощью этого инструмента можно провести парсинг страницы, выделить нужные элементы и структурировать полученную информацию. BeautifulSoup обладает простым и понятным синтаксисом, что делает ее удобной для начинающих пользователей.

Scrapy - это более мощный и гибкий инструмент для парсинга, который позволяет создавать распределенные системы извлечения данных. С его помощью можно проводить парсинг нескольких страниц одновременно, обрабатывать большие объемы данных и управлять процессом парсинга с использованием различных настроек и параметров.

Библиотека requests предоставляет возможность отправки HTTP запросов и получения ответов от web сервера. С ее помощью можно получить доступ к содержимому web страницы, загрузить необходимые данные и использовать их для дальнейшего анализа. Requests позволяет управлять различными параметрами запроса, обрабатывать куки, заголовки и другие аспекты взаимодействия с сервером.

В зависимости от конкретной задачи и требований к парсингу, можно выбрать подходящую библиотеку из представленных. Каждая из них обладает своими особенностями и преимуществами, которые могут быть полезны при автоматизации процесса парсинга web страниц.

3. Парсинг многих страниц

Автоматизация сбора данных с нескольких страниц одновременно

Автоматизация сбора данных с нескольких страниц одновременно - это один из ключевых инструментов современных исследований и аналитики. С возрастанием объема данных, доступных в интернете, скорость и эффективность сбора информации становятся все более важными для профессионалов в различных областях.

Для автоматизации сбора данных с нескольких страниц одновременно могут использоваться различные инструменты и технологии. Например, web скрапинг - это процесс извлечения данных с web сайтов без необходимости ручного взаимодействия с ними. С помощью специальных программ и скриптов можно программно обходить несколько страниц с данными и автоматически собирать необходимую информацию.

Еще одним способом является использование API (Application Programming Interface) - это набор протоколов и инструментов, который позволяет приложениям взаимодействовать друг с другом. Многие web сервисы предоставляют свои API для получения данных, что значительно упрощает процесс их сбора.

Важно помнить, что при автоматизации сбора данных необходимо соблюдать законы о защите информации и правила использования данных, установленные web сайтом. Незаконный сбор данных или нарушение правил использования информации может привести к юридическим последствиям.

Тем не менее, правильно настроенная автоматизация сбора данных позволяет значительно ускорить процесс исследований и аналитики, снизить вероятность ошибок и повысить общую эффективность работы. В итоге, профессионалы в различных областях получают более точные и полезные данные для принятия более обоснованных решений.

Работа с API сайтов для получения данных

API (Application Programming Interface) - это набор инструментов и правил, которые позволяют разработчикам взаимодействовать с внешними программами через сторонние приложения. Использование API стало неотъемлемой частью современной разработки программного обеспечения, особенно в контексте работы с данными из различных источников.

Для работы с API сайтов и получения данных необходимо выполнить несколько шагов. Во-первых, необходимо найти документацию по API нужного сайта, чтобы понять, какие запросы можно делать и какие данные можно получить. Далее следует зарегистрироваться в качестве разработчика на сайте и получить API ключ для доступа к данным.

После получения API ключа можно приступить к написанию кода для работы с API. Для этого используются HTTP запросы к API сайта с использованием нужного метода (GET, POST, PUT, DELETE) и передачей параметров запроса. Полученные данные обычно возвращаются в формате JSON или XML, который затем можно обработать и использовать в своем приложении.

Важно помнить о том, что при работе с API сайтов необходимо соблюдать правила использования и не нарушать ограничения, установленные разработчиками API. Также стоит учитывать возможные сбои в работе API и реагировать на них адекватно.

В целом, работа с API сайтов для получения данных требует определенных навыков программирования и понимания принципов работы API. Однако при правильном подходе это открывает широкие возможности для обогащения своего приложения данными из внешних источников и улучшения пользовательского опыта.

Использование многопоточности или асинхронных запросов для ускорения процесса парсинга

Многопоточность позволяет выполнять несколько задач одновременно, что позволяет эффективно использовать ресурсы процессора. Например, если у нас есть большой объем данных, который нужно обработать, мы можем разделить его на несколько частей и обрабатывать каждую часть в отдельном потоке. Таким образом, мы сможем сократить общее время обработки данных. Однако при использовании многопоточности необходимо учитывать возможные проблемы, такие как гонки данных или блокировки.

Асинхронные запросы позволяют отправлять запросы на сервер и продолжать выполнение кода, не ожидая ответа от сервера. Это позволяет ускорить обработку данных, так как не тратится время на ожидание ответа. Однако при использовании асинхронных запросов необходимо обращать внимание на обработку ошибок и контроль над потоками выполнения.

Используя как многопоточность, так и асинхронные запросы вместе, мы можем значительно увеличить производительность нашего приложения. Например, мы можем параллельно отправлять асинхронные запросы на сервер для получения данных и обрабатывать полученную информацию в нескольких потоках. Это позволит нам сэкономить время и улучшить пользовательский опыт.

Использование многопоточности и асинхронных запросов требует опыта и внимательного планирования, чтобы избежать возможных проблем. Однако, при правильном подходе, эти техники могут значительно ускорить процесс парсинга данных и повысить эффективность нашего приложения.

4. Примеры инструментов и технологий для парсинга многих страниц

Парсинг данных с различных сайтов: новостных порталов, интернет-магазинов, социальных сетей и так далее.

Парсинг данных - это процесс сбора информации с различных ресурсов интернета с целью последующего анализа или использования в своих целях. На сегодняшний день парсинг данных является неотъемлемой частью работы многих компаний и специалистов в различных областях.

Одним из наиболее популярных направлений парсинга данных является сбор информации с новостных порталов. Благодаря этому процессу можно оперативно получать актуальные новости и аналитические материалы для последующего использования в разработке своих проектов или принятия важных решений.

Также, парсинг данных с интернет-магазинов позволяет отслеживать цены на товары, анализировать ассортимент и конкурентов, а также делать прогнозы по спросу на определенные товары. Это помогает компаниям быть в курсе всех изменений на рынке и адекватно реагировать на них.

Социальные сети также являются важным источником данных для парсинга. С их помощью можно анализировать поведение пользователей, выявлять тренды, мнения и предпочтения аудитории. Это позволяет компаниям более точно настраивать свои рекламные кампании и стратегии продвижения.

В целом, парсинг данных позволяет собирать и анализировать огромные объемы информации из различных источников, что помогает принимать обоснованные решения и оперативно реагировать на изменения в бизнес-среде.

Использование сервисов для мониторинга и анализа данных

Сервисы для мониторинга и анализа данных - важное средство для успешной работы любого бизнеса в наше время. Эти инструменты позволяют отслеживать и анализировать различные показатели и метрики, что помогает принимать обоснованные решения и оптимизировать процессы в компании.

Одним из основных преимуществ использования сервисов для мониторинга и анализа данных является возможность получать актуальную информацию в реальном времени. Благодаря автоматизации процессов сбора и анализа данных, компании могут оперативно реагировать на изменения во внешней среде или внутренних процессах.

Кроме того, сервисы для мониторинга и анализа данных позволяют проводить глубокий анализ больших объемов информации, что помогает выявить скрытые закономерности и тенденции. Это позволяет делать более точные прогнозы и строить эффективные стратегии развития бизнеса.

Важно отметить, что выбор подходящего сервиса для мониторинга и анализа данных зависит от конкретных потребностей компании. Некоторые сервисы специализируются на анализе социальных медиа, другие - на анализе финансовых показателей. Поэтому перед выбором сервиса необходимо провести анализ своих потребностей и задач.

Использование сервисов для мониторинга и анализа данных становится неотъемлемой частью успешной деятельности любой компании. Эти инструменты помогают принимать обоснованные решения, оптимизировать процессы и повышать эффективность бизнеса.

5. Практическое применение

Кейсы успешного сбора и анализа данных с нескольких сайтов одновременно

Для успешного сбора и анализа данных с нескольких сайтов одновременно необходимо применять специальные инструменты и методики. Во-первых, важно определить цели и задачи исследования, чтобы правильно выбрать данные для анализа. Затем необходимо выбрать инструменты для сбора данных с различных сайтов.

Один из самых эффективных способов сбора данных с нескольких сайтов - использование web скрейпинга. Это процесс автоматизированного сбора данных с web сайтов с последующей их обработкой и анализом. Для этого можно использовать специальные программы, библиотеки и сервисы, которые позволяют собирать информацию со страниц сайтов и преобразовывать ее в удобный для анализа формат.

Кроме того, для успешного сбора и анализа данных с нескольких сайтов одновременно необходимо учитывать различные особенности каждого из источников. Например, некоторые сайты могут иметь ограничения на скорость сбора данных, другие могут требовать авторизации пользователя для доступа к определенным данным. Поэтому важно провести предварительный анализ и подготовку перед началом сбора данных.

Важным аспектом при работе с несколькими сайтами одновременно является также обработка и анализ полученных данных. Для этого можно использовать различные инструменты и методики, такие как статистический анализ, машинное обучение и другие. Это позволит выявить закономерности, тренды и важные инсайты на основе данных с различных источников.

Таким образом, успешный сбор и анализ данных с нескольких сайтов одновременно требует комплексного подхода, включающего выбор инструментов, проведение предварительного анализа, обработку данных и анализ результатов. Правильное применение всех этих шагов позволит получить ценные знания и информацию для принятия правильных решений на основе данных.

Советы по организации процесса парсинга многих страниц

При организации процесса парсинга многих страниц необходимо учитывать несколько важных моментов, чтобы результат был максимально эффективным. Во-первых, следует правильно выбрать инструмент для парсинга данных. На рынке существует множество специализированных программ и библиотек, способных облегчить этот процесс. Например, Python имеет библиотеки BeautifulSoup и Scrapy, которые хорошо зарекомендовали себя в сфере web парсинга.

Во-вторых, необходимо продумать архитектуру парсера. Это включает в себя определение структуры данных и решение вопросов обработки ошибок и управления потоками. Важно также учитывать возможные блокировки и ограничения, которые могут быть наложены сервером сайта.

Далее, важно определить частоту запросов к сайту и организовать обход большого количества страниц без вызывания подозрений у сервера. Это может потребовать настройки прокси-серверов или использования техник ротации IP-адресов.

Кроме того, необходимо уделить внимание обработке и хранению полученных данных. Важно определить структуру базы данных, в которой будут храниться собранные данные, а также предусмотреть механизмы регулярного обновления информации.

В целом, организация процесса парсинга многих страниц требует внимательного подхода и комплексного подхода. Следуя вышеперечисленным советам, можно добиться успешного сбора и анализа данных с больших объемов страниц.